Это нужно для того, чтобы пользователи сразу понимали, что иллюстрация, видео или аудио сгенерированы нейросетью.

Российский депутат Андрей Свинцов призвал маркировать созданный искусственным интеллектом (ИИ) контент в интернете. По его словам, это нужно для того, чтобы пользователи сразу понимали, что иллюстрация, видео или аудио созданы нейросетью.

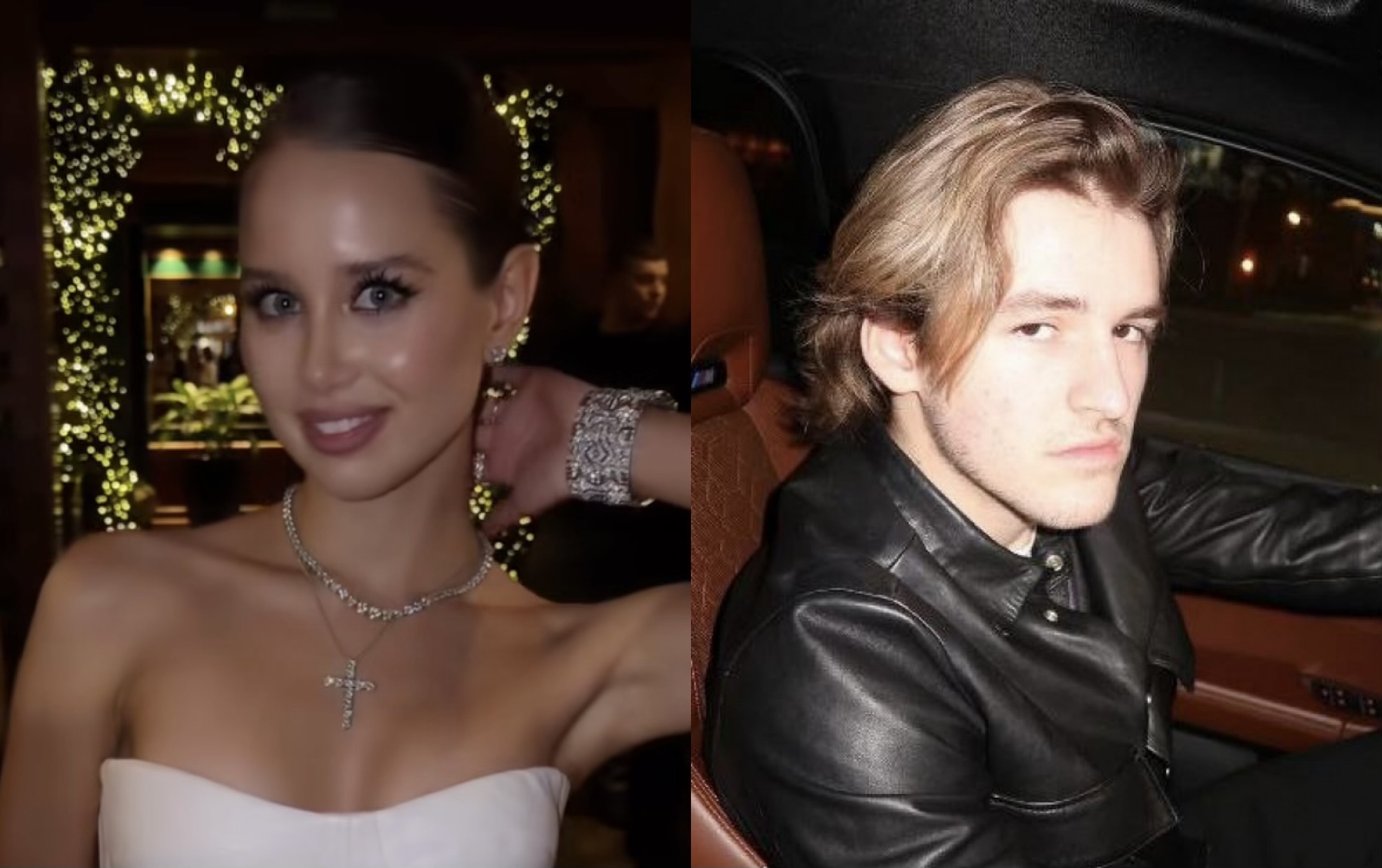

«Интернет заполонил контент в виде deepfake — это подмена лиц на видео- и фотоизображениях. Этот контент иногда может быть очень негативным, потому что может компрометировать кого-то», — цитирует депутата портал «Лента.ру».

То же самое касается и различных голосовых помощников с тембрами, созданными нейросетями, так как такие технологии активно развиваются, а через какое-то время человек будет не в состоянии отличить то, чей голос — компьютерной программы или нет.

Ранее представители Российской православной церкви (РПЦ) призвали запретить ИИ с человеческим лицом и призвали обязательно помечать нейросети. По мнению церкви, человек должен понимать, что общается с искусственным интеллектом.

Помимо этого, должны быть введены и другие запреты. Так, доступа к нейросетям не должно быть у несовершеннолетних, так как это может повлиять на детскую психику. Также нужна локализация западных нейросетей под российскую инфраструктуру и телекоммуникационные сети, а также адаптация их под российскую этику, ведь она часто отличается от западной.

В Госдуме считают, что эти вопросы как минимум нужно обсудить, а уже потом принимать решения.

Нейросети и всё, что с ними связано пользуются в последнее время популярностью. Современные технологии помогают создавать изображения, видео, музыку, писать коды, управлять целыми системами. Однако помимо этого возникают и этические и правовые вопросы — например, по поводу создания дипфейков.

Дипфейк — это технология, позволяющая с помощью машинного обучения моделировать поведение и внешность человека на видеозаписи. Имя технология получила от сочетания deep learning («глубокое обучение») и fake («подделка»).

Фейковые видео могут быть вполне легальными. Лондонский стартап Synthesia занимается созданием видеоаватаров реальных людей. В основном — для корпоративных видеороликов, а также для общения с клиентами и внутреннего обучения. Например, британская компания Ernst & Young (EY) уже использует видеоаватары для общения сотрудников с клиентами вместо личных встреч. При этом компания делает видеоаватары людей, которые дали на это согласие.

В большинстве стран мира четкого регулирования дипфейков не существует, хотя разговоры об их опасности не утихают. В России специального законодательства, связанного с созданными ИИ аудио, фото и видео ещё нет.

А вот в Китае при публикации дипфейков надо ставить специальные пометки, а если этого не сделано, то это уже уголовное преступление.

Есть похожий закон и в штате Калифорния, США — он запрещает публикацию изображений, аудио или видео, которые могут повлиять на восприятие слов или действий политиков и публичных личностей.

В Японии наказывают за дипфейки с порно. В 2021 году там осудили мужчину, который с помощью технологий заменил размытые гениталии (требования японского законодательства) на неразмытые. Это видео он потом продавал.

Между тем, дипфейки уже прочно входят в нашу жизнь. Недавно дипфейковый ролик с Путиным, пытающимся разбудить спящего Байдена, взорвал соцсети. Создано было видео при помощи нейросетей, в кадре — Путин будит «сонного Джо» разными способами, и тот просыпается в весьма неожиданный момент.

Недавно украинский телеканал СТБ с помощью нейросети заменил лицо российского актера, снявшегося в сериале «Последнее письмо любимого». Прохор Дубравин сильно удивился такому повороту событий: его лицо заменили лицом украинского актера Дмитрия Саранскова.

В августе 2021 года в рунете стал вирусным ролик о выборах с министром иностранных дел РФ Сергеем Лавровым, главврачом больницы №40 в Коммунарке Денисом Проценко и министром обороны РФ Сергеем Шойгу. В действительности в съемках ролика они не участвовали, использовались их цифровые копии.

А в 2020 году американская компания RepresentUS выпустила в 2020 году два ролика с цифровыми копиями президента России Владимира Путина и главы КНДР Ким Чен Ына. На видео они демократический строй США и заявляют, что они не будут вмешиваться в президентские выборы. Правда, голос фейкового Путина не похож на настоящий.

Пока технологии не идеальны и выявить дипфейк достаточно просто — где-то лица совсем не похожи, где-то есть размытия и странные движения, а где-то не похож голос.

Ранее «Блокнот» сообщал, что сербский доброволец откровенно рассказал об издевательствах ВСУ над русскими.